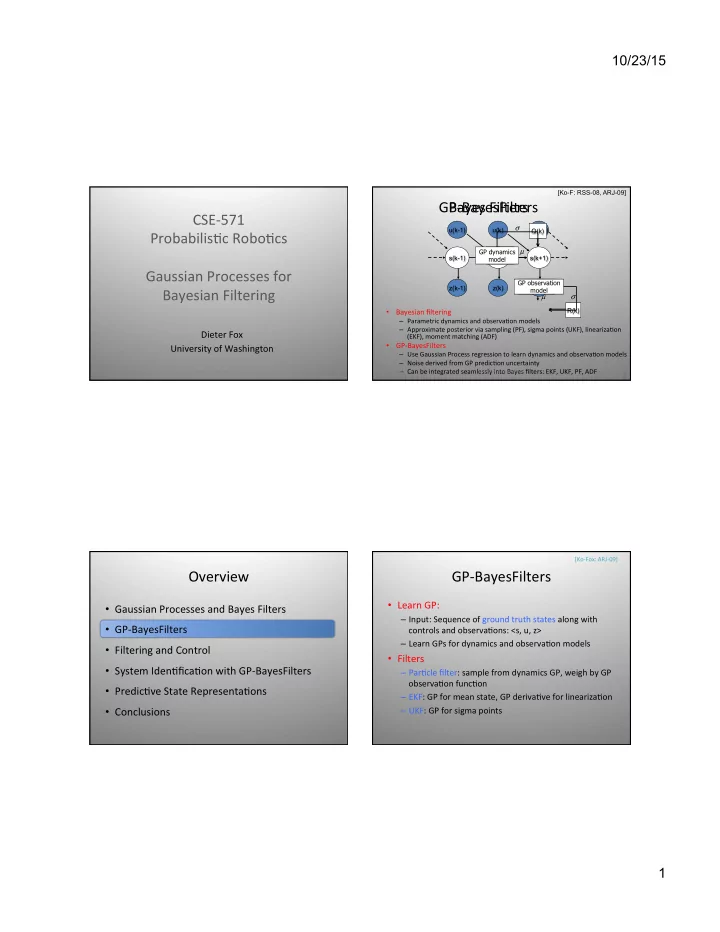

10/23/15 [Ko-F: RSS-08, ARJ-09] GP-‑BayesFilters ¡ Bayes ¡Filters ¡ CSE-‑571 ¡ σ u(k-1) u(k) u(k+1) Q(k) Probabilis1c ¡Robo1cs ¡ µ ¡ GP dynamics Dynamics s(k-1) model s(k) s(k+1) model Gaussian ¡Processes ¡for ¡ Observation GP observation z(k-1) z(k) z(k+1) Bayesian ¡Filtering ¡ model model µ σ R(k) • Bayesian ¡filtering ¡ – Parametric ¡dynamics ¡and ¡observa1on ¡models ¡ – Approximate ¡posterior ¡via ¡sampling ¡(PF), ¡sigma ¡points ¡(UKF), ¡lineariza1on ¡ Dieter ¡Fox ¡ (EKF), ¡moment ¡matching ¡(ADF) ¡ • GP-‑BayesFilters ¡ University ¡of ¡Washington ¡ – Use ¡Gaussian ¡Process ¡regression ¡to ¡learn ¡dynamics ¡and ¡observa1on ¡models ¡ ¡ – Noise ¡derived ¡from ¡GP ¡predic1on ¡uncertainty ¡ – Can ¡be ¡integrated ¡seamlessly ¡into ¡Bayes ¡filters: ¡EKF, ¡UKF, ¡PF, ¡ADF ¡ Amazon ¡ Dieter ¡Fox: ¡GP-‑BayesFilters ¡ 1 ¡ Amazon ¡ Dieter ¡Fox: ¡GP-‑BayesFilters ¡ 2 ¡ [Ko-‑Fox: ¡ARJ-‑09] ¡ Overview ¡ GP-‑BayesFilters ¡ • Learn ¡GP: ¡ ¡ • Gaussian ¡Processes ¡and ¡Bayes ¡Filters ¡ – Input: ¡Sequence ¡of ¡ground ¡truth ¡states ¡along ¡with ¡ • GP-‑BayesFilters ¡ controls ¡and ¡observa1ons: ¡<s, ¡u, ¡z> ¡ – Learn ¡GPs ¡for ¡dynamics ¡and ¡observa1on ¡models ¡ • Filtering ¡and ¡Control ¡ • Filters ¡ • System ¡Iden1fica1on ¡with ¡GP-‑BayesFilters ¡ – Par1cle ¡filter: ¡sample ¡from ¡dynamics ¡GP, ¡weigh ¡by ¡GP ¡ observa1on ¡func1on ¡ • Predic1ve ¡State ¡Representa1ons ¡ – EKF: ¡GP ¡for ¡mean ¡state, ¡GP ¡deriva1ve ¡for ¡lineariza1on ¡ • Conclusions ¡ – UKF: ¡GP ¡for ¡sigma ¡points ¡ Amazon ¡ Dieter ¡Fox: ¡GP-‑BayesFilters ¡ 3 ¡ Amazon ¡ Dieter ¡Fox: ¡GP-‑BayesFilters ¡ 4 ¡ 1

10/23/15 Learning ¡GP ¡Dynamics ¡and ¡ GP-‑PF ¡Propaga1on ¡ Observa1on ¡Models ¡ • Ground ¡truth ¡training ¡sequence: ¡ S k S k + 1 S = [ s 1 , s 2 ,..., s n ], Z = [ z 1 , z 2 ,..., z n ], U = [ u 1 , u 2 ,..., u n ] for m = 1... M : • Learn ¡observa1on ¡and ¡dynamics ¡GPs: ¡ ( ) + sample GP ( ) m = GP s k + 1 µ s k m , u Σ ( s k m ) GP observation s z k k model ¡ Δ s k = s k + 1 − s k GP dynamics [ ] s , k u model k • Propagate each particle using GP prediction = Δ s k − f ( s k , u k ) [ ] EGP dynamics r s , k u • Sample from GP uncertainty k model k • One GP mean and variance prediction per particle • Learn ¡separate ¡GP ¡for ¡each ¡output ¡dimension ¡ • Diagonal ¡noise ¡matrix ¡ 5 ¡ Amazon ¡ Dieter ¡Fox: ¡GP-‑BayesFilters ¡ 6 ¡ Amazon ¡ Dieter ¡Fox: ¡GP-‑BayesFilters ¡ [Deisenroth-etal] introduced GP-ADFs and EP for smoothing in GP dynamical systems GP-‑EKF ¡Propaga1on ¡ GP-‑UKF ¡Propaga1on ¡ µ k , ∑ k µ k + 1 , ∑ k + 1 ( ) µ k , ∑ k µ k + 1 , ∑ k + 1 χ k = µ k − γ ∑ k µ k , µ k + γ ∑ k , µ k + 1 = GP µ ( µ k ) for i = 0...2 n : χ k + 1 = GP µ ( χ k ) G = ∂ GP µ ( µ k ) 2 n ∑ ∂ s µ k + 1 = ω m χ k + 1 i i ∑ k + 1 = G ∑ k G T + GP i = 0 Σ ( µ k ) 2 n ∑ ∑ k + 1 = ω c i ( χ k + 1 − µ k + 1 )( χ k + 1 − µ k + 1 ) T + GP Σ ( µ k ) i i i = 0 • Propagate mean using GP prediction • Propagate ¡each ¡sigma ¡point ¡using ¡GP ¡predic1on ¡ • Use gradient of GP to propagate covariance • 2d+1 ¡sigma ¡points ¡-‑> ¡2d+1 ¡GP ¡mean ¡predic1ons ¡ Amazon ¡ Dieter ¡Fox: ¡GP-‑BayesFilters ¡ 7 ¡ Amazon ¡ Dieter ¡Fox: ¡GP-‑BayesFilters ¡ 8 ¡ 2

10/23/15 [Ferris-‑Haehnel-‑Fox: ¡RSS-‑06] ¡ Overview ¡ WiFi-‑Based ¡Loca1on ¡Es1ma1on ¡ • Gaussian ¡Processes ¡and ¡Bayes ¡Filters ¡ • GP-‑BayesFilters ¡ • Filtering ¡and ¡Control ¡ Mean ¡ • System ¡Iden1fica1on ¡with ¡GP-‑BayesFilters ¡ • Predic1ve ¡State ¡Representa1ons ¡ • Conclusions ¡ Variance ¡ Similar to [Schwaighofer-etal: NIPS-03] ¡ 10 ¡ Amazon ¡ Dieter ¡Fox: ¡GP-‑BayesFilters ¡ Amazon ¡ Dieter ¡Fox: ¡GP-‑BayesFilters ¡ 9 ¡ Building ¡Model ¡ Tracking ¡Example ¡ Amazon ¡ Dieter ¡Fox: ¡GP-‑BayesFilters ¡ 11 ¡ Amazon ¡ Dieter ¡Fox: ¡GP-‑BayesFilters ¡ 12 ¡ 3

10/23/15 [Ko-‑F: ¡ARJ-‑09] ¡ Blimp ¡Testbed ¡ GP-‑UKF ¡Tracking ¡Example ¡ • Task: Track a blimp with two webcams • Baseline: Parametric model that takes drag, thrust, gravity, etc, into account • Blue ¡ellipses: ¡sigma ¡points ¡projected ¡into ¡observa1on ¡space ¡ • GP-BayesFilters and parametric model trained on ground truth data • Green ¡ellipse: ¡Mean ¡state ¡es1mate ¡ obtained with Vicon motion capture system Amazon ¡ 13 ¡ Dieter ¡Fox: ¡GP-‑BayesFilters ¡ Amazon ¡ Dieter ¡Fox: ¡GP-‑BayesFilters ¡ 14 ¡ Dealing ¡with ¡Training ¡Data ¡Sparsity ¡ Tracking ¡Results ¡ ¡ ¡ ¡ ¡ Full ¡process ¡model ¡tracking ¡ Percentage reduction in RMS over parametric baseline ¡ • Parametric ¡model ¡takes ¡drag, ¡thrust, ¡gravity, ¡etc, ¡into ¡account ¡ ¡ • Cross ¡valida1on ¡with ¡900 ¡1mesteps ¡for ¡training ¡ No ¡right ¡turn ¡process ¡model ¡tracking ¡ • hetGP: ¡Heteroscedas1c ¡GP ¡with ¡variable ¡noise ¡ [Kers1ng-‑etal: ¡ICML-‑07] ¡ • Training ¡data ¡for ¡right ¡turns ¡removed ¡ • sparseGP: ¡sparsified ¡to ¡50 ¡ac1ve ¡points ¡ [Snelson-‑Ghahramani: ¡NIPS-‑06] ¡ Amazon ¡ Dieter ¡Fox: ¡GP-‑BayesFilters ¡ 15 ¡ Amazon ¡ Dieter ¡Fox: ¡GP-‑BayesFilters ¡ 16 ¡ 4

10/23/15 ACT ¡Hand ¡Tendon ¡Arrangements ¡ ACT ¡Hand ¡Control ¡ • Tendon ¡hood ¡structure ¡for ¡extensors ¡ – Cri1cal ¡for ¡preserving ¡hand ¡func1onality ¡ – Slides ¡over ¡the ¡bones ¡and ¡joints ¡ • We ¡have ¡non-‑linear, ¡non-‑constant ¡rela1onships ¡ between ¡muscles ¡and ¡joints ¡ 1. Inves1ga1on ¡of ¡muscle-‑joint ¡kinema1cal ¡rela1onship ¡ 2. How ¡to ¡control ¡joints ¡with ¡muscles? ¡ ¡ ¡ Amazon ¡ Dieter ¡Fox: ¡GP-‑BayesFilters ¡ 17 ¡ Amazon ¡ Dieter ¡Fox: ¡GP-‑BayesFilters ¡ 18 ¡ [Wilkinson et al, ICRA 03] GP-‑Based ¡Control ¡ Overview ¡ • Gaussian ¡Processes ¡and ¡Bayes ¡Filters ¡ • GP-‑BayesFilters ¡ • Filtering ¡and ¡Control ¡ • System ¡Iden1fica1on ¡with ¡GP-‑BayesFilters ¡ • Predic1ve ¡State ¡Representa1ons ¡ • Conclusions ¡ Amazon ¡ Dieter ¡Fox: ¡GP-‑BayesFilters ¡ 19 ¡ Amazon ¡ Dieter ¡Fox: ¡GP-‑BayesFilters ¡ 20 ¡ 5

10/23/15 [Ko-F: RSS-09, ARJ-10] GP ¡Latent ¡Variable ¡Models ¡ GP ¡Latent ¡Variable ¡Models ¡ u u u u 1 2 3 n • Some1mes ¡ground ¡truth ¡states ¡are ¡not ¡or ¡only ¡ s s s s par1ally ¡available ¡ GP GP 1 2 3 n … GP GP GP GP • Instead ¡of ¡op1mizing ¡over ¡GP ¡hyperparameters ¡ z z z z 1 2 3 n only, ¡op1mize ¡over ¡latent ¡states ¡ S ¡as ¡well ¡ • Latent ¡variable ¡models ¡ [Lawrence: ¡NIPS-‑03, ¡Wang-‑etal: ¡PAMI-‑08] ¡ • Learn ¡latent ¡states ¡and ¡GPs ¡in ¡one ¡op1miza1on ¡ ) argmax S , Θ Z , Θ S log p ( S , Θ Z , Θ S | Z , U , S ) + log p ( Θ Z ) + log p ( Θ S ) + const = log p ( Z | S , Θ Z ) + log p ( S | U , Θ S ) + log p ( S | S • Can ¡take ¡noisy ¡labels ¡into ¡account ¡ Amazon ¡ Dieter ¡Fox: ¡GP-‑BayesFilters ¡ 21 ¡ Amazon ¡ Dieter ¡Fox: ¡GP-‑BayesFilters ¡ 22 ¡ Slotcar ¡Testbed ¡ Simple ¡Trajectory ¡Replay ¡ • Learning ¡ ¡ u 1 u 2 – Human ¡demonstrates ¡control ¡ – Learn ¡latent ¡states ¡using ¡GPBF-‑Learn ¡ GP GP u ¡ u ¡ – Learn ¡mapping ¡from ¡state ¡to ¡control ¡ s s GP 1 2 S ¡ • Replay ¡ ¡ GP GP – Track ¡state ¡using ¡GP-‑BayesFilter ¡ z ¡ z ¡ – Use ¡control ¡given ¡by ¡control ¡GP ¡ z 1 z 2 • Track ¡contains ¡banked ¡curves, ¡eleva1on ¡changes ¡ • Custom ¡IMU ¡with ¡gyro ¡and ¡accelerometer ¡built ¡by ¡Intel ¡Research ¡Seakle ¡ Observa1ons ¡very ¡noisy, ¡perceptual ¡aliasing ¡ • Amazon ¡ Dieter ¡Fox: ¡GP-‑BayesFilters ¡ 23 ¡ Amazon ¡ Dieter ¡Fox: ¡GP-‑BayesFilters ¡ 24 ¡ 6

Recommend

More recommend