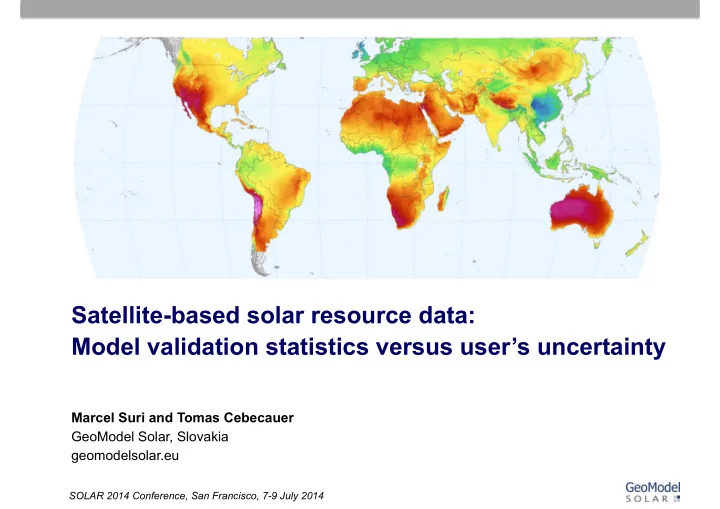

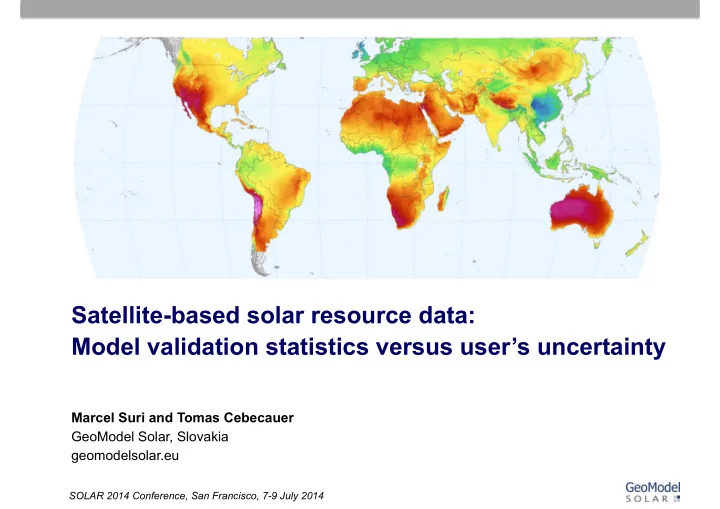

Satellite-based solar resource data: Model validation statistics versus user’s uncertainty Marcel Suri and Tomas Cebecauer GeoModel Solar, Slovakia geomodelsolar.eu SOLAR 2014 Conference, San Francisco, 7-9 July 2014 SOLAR 2014 Conference, San Francisco, 7-9 July 2014 [1]

About GeoModel Solar Development and operation of SolarGIS online system • Solar resource and meteo database • PV simulation software • Data services for solar energy and PV: • Planning • Monitoring • Forecasting Consultancy and expert services • Solar resource assessment • PV yield and performance assessment • Country studies http://solargis.info SOLAR 2014 Conference, San Francisco, 7-9 July 2014 [2]

Topics 1. Satellite-based models 2. On-site measurements 3. Measures of model uncertainty 4. User’s uncertainty 5. Conclusions SOLAR 2014 Conference, San Francisco, 7-9 July 2014 [3]

Observa(ons ¡ • Measured ¡data ¡are ¡by ¡default ¡considered ¡more ¡accurate ¡than ¡the ¡ modeled ¡values ¡ • In ¡many ¡cases ¡solar ¡measuring ¡sta7ons ¡are ¡operated ¡by ¡staff ¡ ¡ with ¡limited ¡experience ¡and ¡knowledge ¡ • Interannual ¡variability ¡is ¡s7ll ¡not ¡fully ¡understood ¡ • Concept ¡of ¡data ¡uncertainty ¡is ¡not ¡clear ¡in ¡solar ¡industry ¡ ¡ SOLAR 2014 Conference, San Francisco, 7-9 July 2014 [4]

How ¡to ¡acquire ¡solar ¡resource ¡data ¡ Satellite-‑based ¡models ¡ • Extensive ¡geographical ¡coverage ¡and ¡con7nuity ¡ • Historical ¡availability ¡(12 ¡to ¡20+ ¡years ¡available) ¡ • Spa7al ¡and ¡temporal ¡stability ¡ ¡ On-‑site ¡measurements ¡ Source: SolarGIS • Accuracy ¡ • Frequency ¡of ¡measurements ¡ ¡ Source: GeoSUN Africa SOLAR 2014 Conference, San Francisco, 7-9 July 2014 [5]

Satellite-‑based ¡models ¡ Models ¡based ¡on ¡sound ¡theore(cal ¡grounds ¡ • Best ¡available ¡approaches ¡ ¡ (clear-‑sky, ¡cloud, ¡components, ¡terrain, ¡transposi7on) ¡ • Regionally ¡and ¡temporally ¡consistent ¡ ¡ • Fast ¡and ¡computa7onally ¡stable ¡ ¡ Input ¡data: ¡satellite, ¡aerosols, ¡water ¡vapor, ¡... ¡ • Global ¡data ¡sets ¡ • "High" ¡resolu7on ¡(spa7al ¡and ¡temporal) ¡ • Systema7cally ¡updated ¡ • Quality ¡controlled ¡and ¡validated ¡ ¡ Support ¡data ¡and ¡algorithms ¡ SOLAR 2014 Conference, San Francisco, 7-9 July 2014 [6]

Satellite-‑based ¡models ¡− ¡accuracy ¡ Regionally ¡variable: ¡ • satellite ¡viewing ¡geometry ¡ • specific ¡high ¡albedo ¡surfaces ¡(snow, ¡salty ¡lakes, ¡white ¡sand ¡deserts,…) ¡ • tropical ¡cloud ¡forma7ons ¡ • high ¡polluted ¡areas, ¡quality ¡of ¡aerosol ¡inputs ¡ • … ¡ Regional ¡paTerns ¡have ¡systema7c ¡character ¡– ¡space ¡for ¡improvement ¡ ¡ SOLAR 2014 Conference, San Francisco, 7-9 July 2014 [7]

Satellite-‑based ¡models ¡− ¡interannual ¡variability ¡ Availability ¡of ¡satellite ¡data: ¡ • Data ¡for ¡15+ ¡(12+) ¡and ¡20+ ¡years ¡available ¡ • Large ¡volcano ¡erup7ons ¡not ¡considered ¡ ¡ (stratosferic ¡aerosols) ¡ ¡ Limited ¡availability ¡of ¡atmospheric ¡data ¡ (MACC-‑II ¡from ¡2003, ¡satellite ¡based ¡from ¡2000) ¡ ¡ PRIME IODC GOES ¡East Pacific GOES ¡West 0° 57.5° -‑75° 145° -‑135° 2013 2012 2011 MTSAT ¡1,2 MSG ¡1,2,3 2010 2009 GOES ¡8,12,13,14 GOES ¡10, ¡11, ¡15 2008 2007 MFG ¡5,7 2006 2005 2004 2003 GOES ¡9 2002 2001 GMS ¡5 Standard ¡devia7on ¡of ¡yearly ¡ 2000 MFG ¡4-‑7 1999 GHI ¡from ¡the ¡longterm ¡ 1998 1997 average: ¡2% ¡to ¡12% ¡ 1996 1995 1994 SOLAR 2014 Conference, San Francisco, 7-9 July 2014 [8]

On-‑site ¡(ground) ¡measurements ¡ ¡ ¡ ¡ Instruments ¡and ¡their ¡accuracy 1 ¡ ¡ RSR 2 ¡ Pyrheliometers ¡ SPN1 ¡ ¡ ¡ ¡ ¡ Secondary ¡standard ¡ First ¡class ¡ ¡ ¡ ¡ ¡ Direct ¡Normal ¡ ±0.5% ¡ ±1.0% ¡ ±4.5% ¡ ±5% ¡ Irradiance, ¡DNI ¡ RSR 2 ¡ ¡ ¡ Pyranometers ¡ SPN1 ¡ ¡ ¡ Secondary ¡standard ¡ First ¡class ¡ Second ¡class ¡ ¡ ¡ ¡ ¡ GHI ¡ ±2% ¡ ±5% ¡ ±10% ¡ ±4.5% ¡ ±5% ¡ 1 ¡Daily ¡summaries, ¡at ¡95% ¡confidence ¡level ¡in ¡laboratory ¡condi7ons; ¡ ¡ ¡ ¡in ¡real ¡condi7ons ¡assuming ¡rigorous ¡opera7on ¡and ¡maintenance ¡prac7ces ¡ 2 ¡A`er ¡post ¡processing ¡ SOLAR 2014 Conference, San Francisco, 7-9 July 2014 [9]

On-‑site ¡measurements ¡− ¡situa(on ¡today ¡ • Theore7cal ¡knowledge ¡not ¡fully ¡adopted ¡ • Best ¡available ¡technologies ¡are ¡not ¡mainstream ¡ • Lack ¡of ¡experience ¡and ¡unclear ¡standards ¡ ¡ • Site ¡selec7on, ¡sta7on ¡set-‑up ¡ • Cleaning, ¡calibra7on, ¡maintenance, ¡gaps ¡ • Quality ¡control ¡is ¡not ¡always ¡implemented ¡ • Performance ¡in ¡extreme ¡climate ¡unknown ¡ SOLAR 2014 Conference, San Francisco, 7-9 July 2014 [10]

Measures ¡of ¡model ¡accuracy ¡ • Bias: ¡ systema'c ¡model ¡devia'on ¡ • Root ¡Mean ¡Square ¡Devia7on ¡(RMSD) ¡and ¡Mean ¡Average ¡Devia7on ¡ (MAD): ¡ spread ¡of ¡error ¡for ¡instantaneous ¡values ¡ • Correla7on ¡coefficient ¡ • Kolmogorov-‑Smirnoff ¡index ¡(KSI): ¡ representa'veness ¡of ¡distribu'on ¡of ¡ values ¡ ¡ Best-‑accuracy ¡ground ¡measurements ¡are ¡to ¡be ¡used ¡ Data ¡for ¡one ¡single ¡site ¡cannot ¡be ¡used ¡for ¡characteriza7on ¡of ¡a ¡model: ¡ • Microclimate ¡ • Poten7al ¡issues ¡in ¡the ¡measured ¡data ¡ SOLAR 2014 Conference, San Francisco, 7-9 July 2014 [11]

Sta(s(cal ¡indicators ¡of ¡the ¡model ¡performance ¡ Es(mate ¡of ¡longterm ¡yearly ¡values: ¡ ¡ Mean ¡bias ¡(MB) ¡ • Systema7c ¡bias ¡of ¡the ¡model ¡ • Shows ¡tendency ¡of ¡the ¡model ¡to ¡overes7mate ¡or ¡to ¡underes7mate ¡ ¡ Standard ¡devia(on ¡of ¡bias ¡values ¡(STDB) ¡ • Range ¡of ¡devia7on ¡of ¡the ¡model ¡es7mates ¡ • Shows ¡spa7al ¡stability ¡of ¡the ¡model ¡performance ¡ ¡ SOLAR 2014 Conference, San Francisco, 7-9 July 2014 [12]

Example: ¡independent ¡evalua(on ¡ MB MB STDB STDB Ineichen ¡P., ¡2013. ¡Long ¡term ¡satellite ¡hourly, ¡daily ¡and ¡monthly ¡global, ¡beam ¡and ¡ ¡ diffuse ¡irradiance ¡valida7on. ¡interannual ¡variability ¡analysis. ¡University ¡of ¡Geneva, ¡IEA ¡Task ¡46. ¡ SOLAR 2014 Conference, San Francisco, 7-9 July 2014 [13]

User’s ¡uncertainty ¡– ¡longterm ¡es(mate ¡ At sites with no measurements • Standard deviation of bias values for all validation sites (STDEV) • Regional aspects should be considered Probabilistic approach (normal distribution) for uncertainty: • 80% occurrence of values (90% exceedance, P90) solar industry standard, 1.282*STDEV • 95% occurrence of values (97.5% exceedance, P97.5) standard in meteo instruments, 1.960*STDEV SOLAR 2014 Conference, San Francisco, 7-9 July 2014 [14]

User’s ¡uncertainty ¡– ¡longterm ¡es(mate ¡ • Uncertainty of the model relative to the measurements • Uncertainty of measurements • Uncertainty due to interannual variability* * Interannual variability is not in the scope of this presentation SOLAR 2014 Conference, San Francisco, 7-9 July 2014 [15]

User’s ¡uncertainty ¡– ¡longterm ¡es(mate ¡ SolarGIS global performance: estimate of yearly GHI and DNI Uncertainty Model of the model and uncertainty measurements Annual value GHI DNI GHI DNI Uncert. of instruments* - - 2.0 1.0 Number of sites 189 134 189 134 Standard deviation 3.0 6.0 3.6 6.0 of occurrence) 80% P90 3.9 7.6 4.4 7.7 (probability Uncertainty 90% P95 5.0 9.8 5.4 9.9 95% P97.5 5.9 11.7 6.3 11.7 99% P99.5 7.8 15.4 8.1 15.4 * Vuilleumier et al., 2014. Performance evaluation of radiation sensors for the solar energy sector. MACC–II OSC, Brussels. SOLAR 2014 Conference, San Francisco, 7-9 July 2014 [16]

User’s uncertainty − SolarGIS GHI ±4.4%* ±7.7%* DNI * 80% occurrence SOLAR 2014 Conference, San Francisco, 7-9 July 2014 [17]

User’s uncertainty − SolarGIS GHI ±4.4%* ±7.7%* DNI * 80% occurrence SOLAR 2014 Conference, San Francisco, 7-9 July 2014 [18]

Recommend

More recommend